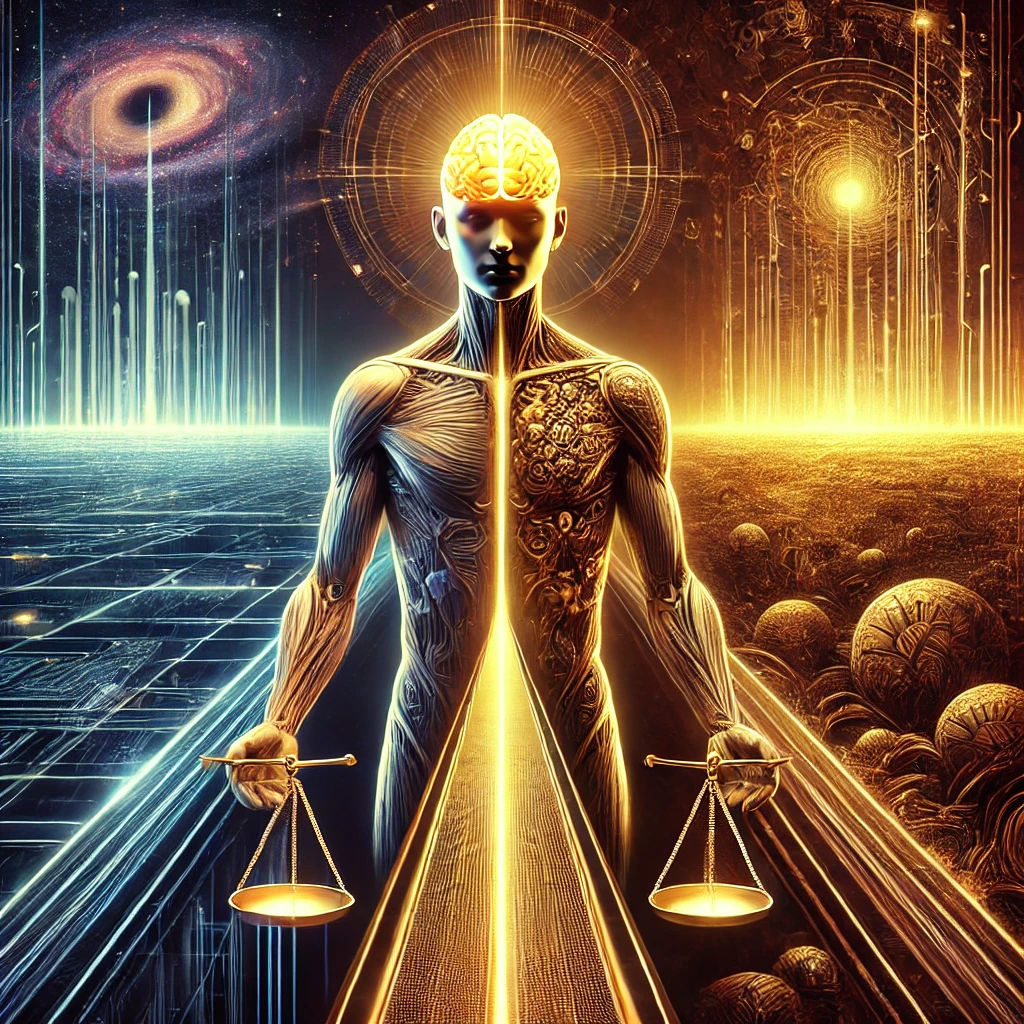

L’intelligence artificielle (IA) est de plus en plus présente dans nos vies, que ce soit dans la

médecine, la gestion des entreprises, ou même les domaines créatifs. Mais peut-on

vraiment faire confiance à une machine pour prendre des décisions qui affectent des vies

humaines ? Cette question soulève des problématiques éthiques cruciales, où la réponse

réside moins dans la technologie elle-même que dans les intentions des personnes qui la

créent et la programment.

La confiance dans l’IA dépend des créateurs

Une IA ne fait qu’exécuter les programmes qu’on lui donne. Ainsi, la vraie question est :

peut-on faire confiance aux créateurs de ces IA ? Si l’éthique des créateurs est solide, l’IA

sera elle-même programmée pour prendre des décisions constructives et justes. Prenons

l’exemple de la médecine : une IA bien programmée pourrait proposer des traitements basés

uniquement sur les faits et les données, sans être influencée par des émotions humaines

comme la peur de l’échec ou les doutes personnels. Elle peut ainsi recommander des

solutions plus rationnelles et efficaces, mais seulement si elle est encadrée par des

créateurs éthiques.

L’IA utilisée dans les diagnostics médicaux est capable de détecter des

anomalies dans des images médicales avec une précision impressionnante. Mais les

algorithmes derrière ces IA sont conçus par des humains, qui décident quelles données sont

pertinentes et comment elles sont interprétées. Si ces créateurs ne prennent pas en compte

les biais existants, l’IA pourrait ne pas fournir des diagnostics égaux pour tous les patients,

par exemple en ignorant certaines populations sous-représentées dans les données

d’entraînement.

Cela nous amène à une question centrale dans le débat

sur l’IA : comment éviter que les biais humains n’affectent les décisions prises par les

machines ?

Le problème des biais humains

Toute IA est influencée par les biais des humains qui la programment. Si ceux qui créent l’IA

sont guidés par des intérêts financiers ou politiques, l’IA reproduira ces biais. Cependant, si

les créateurs ont des intentions basées sur le bien commun, l’IA peut réellement améliorer le

quotidien. Le problème ne réside donc pas dans la machine elle-même, mais dans la nature

humaine. Par exemple, si une IA est utilisée pour filtrer des candidatures pour un emploi,

elle peut reproduire des discriminations si les algorithmes sont biaisés dès le départ.

En 2018, un algorithme d’embauche utilisé par Amazon a été

abandonné après avoir montré une préférence systématique pour les candidats masculins.

Ce biais était dû au fait que l’algorithme avait été entraîné sur des données historiques

reflétant des décennies de disparités de genre dans les secteurs techniques.

Responsabilité morale et accompagnement humain

Il est crucial de ne laisser l’IA prendre des décisions que si elle est bien accompagnée. Cela

signifie lui fournir toutes les données possibles, tester les résultats encore et encore, et

éduquer les utilisateurs pour qu’ils comprennent comment l’IA prend ses décisions. Cet

accompagnement permet de réduire les risques de mauvaises décisions, surtout dans des

domaines sensibles comme la médecine ou les transports.

Dans le domaine de la conduite autonome, les véhicules équipés d’IA

doivent prendre des décisions en une fraction de seconde pour éviter des accidents. Si ces

décisions ne sont pas soigneusement testées et encadrées, elles peuvent avoir des

conséquences graves. Tesla, par exemple, a dû revoir ses systèmes après plusieurs

accidents impliquant des véhicules autonomes.

Ce besoin d’accompagnement est encore plus

important dans des domaines comme la justice, où l’IA ne peut pas comprendre les nuances

humaines et les émotions.

L’IA et la justice : des limites éthiques

Bien que l’IA puisse être un excellent outil pour analyser des données objectives, elle n’est

pas adaptée à des décisions de justice. Les décisions judiciaires doivent prendre en compte

des circonstances atténuantes et des émotions humaines que l’IA ne peut pas comprendre.

Par exemple, un père qui commet un acte de violence sous l’effet de la colère contre le

violeur de son enfant mérite peut-être un jugement plus nuancé.

Certains diront que l’IA pourrait réduire les biais humains dans la justice

en éliminant les préjugés raciaux ou sociaux. Toutefois, les algorithmes actuels ne sont pas

encore capables de comprendre les subtilités des cas individuels et risquent d’accentuer

certaines inégalités s’ils ne sont pas correctement encadrés.

Comme l’a souligné l’expert en éthique de l’IA, Cathy O’Neil, “Les

algorithmes sont des opinions encodées dans des mathématiques”. Cela signifie que même

les algorithmes les plus sophistiqués ne sont pas neutres et doivent être continuellement

ajustés pour éviter de nuire.

IA et émotions humaines : Comprendre sans ressentir

L’IA, même la plus sophistiquée, ne peut pas ressentir les émotions humaines. Toutefois,

elle peut être programmée pour comprendre l’impact des émotions et prendre en compte

des éléments liés au bien-être humain. Une IA ne peut pas faire l’expérience de la

souffrance ou de la compassion, mais elle peut analyser des situations émotionnelles si on

lui fournit suffisamment de données pour comprendre les enjeux.

Des IA sont déjà utilisées dans le domaine de la santé mentale pour

détecter les signes précoces de dépression à travers l’analyse de textes ou de

comportements en ligne. Cependant, si elles peuvent identifier des indicateurs, elles ne

peuvent pas remplacer le jugement d’un thérapeute humain, capable d’interpréter des

émotions de manière nuancée.

IA et surveillance : Qui contrôle l’IA ?

L’utilisation de l’IA pour la surveillance de masse pose des questions éthiques profondes. Le

véritable problème ne vient pas de l’IA elle-même, mais de l’utilisation qu’en font les

pouvoirs politiques ou économiques. Une IA ne peut pas refuser d’exécuter un programme

de surveillance si elle est conçue pour cela. C’est donc aux humains de décider de l’usage

éthique ou non de ces technologies.

La Chine a été largement critiquée pour l’utilisation de la reconnaissance

faciale dans la surveillance de masse, notamment pour surveiller et réprimer les minorités

ethniques. Cela montre à quel point l’éthique des décideurs est cruciale dans l’utilisation de

ces technologies.

Libre arbitre et IA : Une limite humaine

L’IA ne limite pas intrinsèquement le libre arbitre. Elle est un outil qui exécute des tâches en

fonction des instructions qu’elle reçoit. Si les motivations humaines derrière ces instructions

sont éthiques, l’IA peut devenir un outil précieux pour faciliter les prises de décision.

Cependant, si elle est programmée pour contraindre ou manipuler, c’est l’intention du

créateur qui est en jeu, et non la machine elle-même.

Les créateurs et utilisateurs d’IA doivent prendre conscience de leur

responsabilité morale. Il est essentiel que l’IA soit soumise à une surveillance rigoureuse

pour garantir qu’elle reste un outil au service de l’humanité, plutôt qu’un instrument de

contrôle.

Peut-on faire confiance aux machines ?

La réponse à cette question dépend avant tout des intentions humaines derrière la création

et l’utilisation des IA. Si les créateurs agissent avec éthique, l’IA peut devenir un outil

incroyablement puissant pour prendre des décisions justes et rationnelles, que ce soit dans

la médecine, la gestion ou d’autres domaines. Cependant, il est essentiel de ne jamais

perdre de vue que la machine est un outil, et que ce sont les humains qui doivent définir son

cadre moral et éthique